视频 | 另类的AR变脸, 每秒1000帧的3D纵深映射投影

摘要:不知道什么开始,这样的变脸APP就红遍了朋友圈,猫须、偲红、兔耳朵动起来——满足了一大帮少女的萌萌哒“刚需”。而最近有一段跳舞视频也同样火了。

这周的F8大会上,Facebook高调推出 AR 开发者平台 Camera Effects ,小扎还放下豪言:AR 将成为下一代计算平台,但前期硬件还不够好的时候,咱先做个平台欢迎小伙伴一起玩玩。而此前Facebook早已抄过Snapchat,做了类似的变脸应用。

不知道什么开始,这样的变脸APP就红遍了朋友圈,猫须、偲红、兔耳朵动起来——满足了一大帮少女的萌萌哒“刚需”。

而最近有一段跳舞视频也同样火了一阵子:

每秒1000帧的“祈祷”

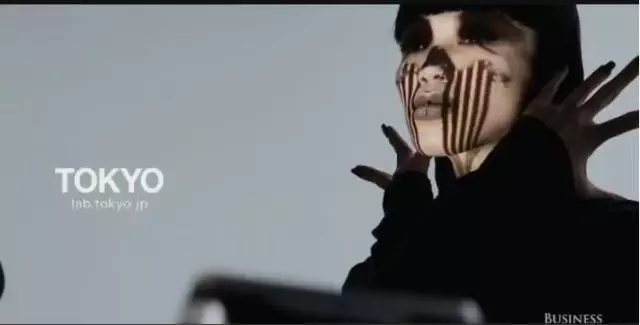

这一段名为《INORI(祈祷)》的舞蹈表演视频,没有华丽的阵容,也没有花俏的动作,时而是丰满的人脸,时而是枯竭的头颅,时而是地狱的使者,时而是虚空的来客。

视频的特点是使用了实时面部投影映射技术,通过改变舞者的面容,在一分钟之内让舞者舞出一段祷告仪式。

这段视频是由艺术家诺布迈克·阿赛(Nobumichi Asai)、日本设计工作室 WOW、日本东京大学石川渡边实验室(Ishikawa Wantanbe)和日本著*舞蹈家 AyaBambi 共同合作设计。

将投影固定在某种媒介上早已司空见惯,我们也见过酷炫的AR投影的餐桌,不过仔细看视频我们发现,舞者的动作是一直在变化而非静止。

这是Faceu的效果,除了脸部意外的特效,视频中投影也已经以假乱真。

普通的投影,直接投影在墙上的内容令人瞎眼;一个人走过投影机前,光线顿时扭曲,形成诡异的效果;甚至镜头的轻微抖动,由于透视的关系,画面都会产生巨大的变形,令人不快。那视频中的神奇变脸是怎么做到的呢?

投影的实现

这是制作过程中用到的投影设备,我们换个角度看看:

根据制作团队描述,舞蹈使用了东京大学设计的高速投影机,每秒运行1000帧的投影(已经达到目前世界最快),通过将投影仪与 3D 纵深映射系统和精确的传感器跟踪一起使用,让视频创作者能够实时地改变舞者的外观和视觉美学。

传统的投影系统很难跟上人体基本动作,比如前几年互联网上大火的 Lady Gaga 脸部投影艺术,而这里高速投影,还能实时追踪人体的舞蹈动作。

《Inori》的创造,实现了投影的10毫秒延时,满足复杂的舞蹈艺术创作的需求,与传统投影系统相比是一次飞跃的进步,也开启了新型视觉艺术的启蒙篇章。

详解 Face Hacking

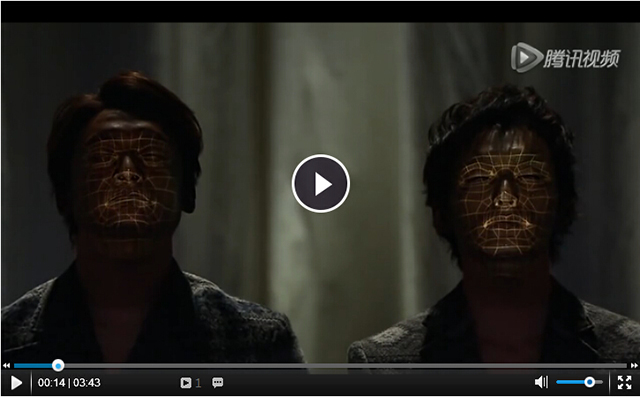

实际上,类似的3D投影映射技术早在2014年就已经出现——这部《FACE HACKING》是毕业于日本东北大学的浅井宣通,于2014年12月22日在FUJI-TV SMAP×SMAP上首次展示的,机器人、豹人等各种充满科幻气势的妆容在演员面部不断演示着。

我们看一下面部映射的流程步骤:

· 用于识别的标记放置于脸部

· 判断标记的 3D 位置

· 根据标记位置判断面部位置及方位

· 渲染脸部 3D 模型,在这个模型上动画纹理和实时效果将会被应用

· 进行面部投影

为了在面部移动时保持自然,以上所有步骤都要处理得尽可能快。

面部映射过程依赖于两个在同一台电脑上同时运行的软件:

· 传感管理软件负责控制传感器和从传感数据中提取 3D 信息

· 面部跟踪和投射映射软件(也叫作现场映射)会估算面部所在的位置以及方位,接着呈现、渲染(也就是画)出 3D 模型,这个 3D 模型会被映射纹理动画视频。

为了能让投射适合艺术家的真实面庞,通过 3D 扫描仪器获得了艺术家脸部的轮廓,从若干不同的角度,这些照片会在 3D 模型上进行贴图、纹理处理,合并到单一参考纹理图像之中,其中包含有所有面部的细节。当创作跟踪效果和动画时,参考纹理贴图会最为基础,以便保持与脸部真实几何结构的严格吻合。

小结

投影式的“AR”表现,不需要特别的标记物,不需要移动设备的另一个屏幕为载体,也不需要AR眼镜等穿戴设备,使得人们在裸眼的条件下就能欣赏到不一样的酷炫特效,当然它的局限性也比较大。不过,这种另类的表现确实也是打开了AR的一扇窗户。除此之外,我还是很好奇跳舞的姑娘,这些灯光照射在脸上会不会刺眼和头晕呢?

责编:小艳

来源:AR酱

欢迎投稿

QQ:2548416895

邮箱:yejibang@yejibang.com

或 yejibang@126.com

每天会将您订阅的信息发送到您订阅的邮箱!

陕公网安备 61019002000416号

陕公网安备 61019002000416号

业务咨询

业务咨询